Vous avez un site internet, vous faites un gros travail sur la rédaction de contenus, mais vous vous rendez compte que vos articles ne ressortent pas dans Google… Peut-être avez-vous un problème d’indexation ?

En effet, pour que Google positionne vos pages dans ses résultats, il faut dans un premier temps qu’il soit en capacité d’y accéder, et dans un second temps qu’il puisse les enregistrer.

On parle dès lors de crawlabilité et indexation. Dans cet article, je vais essayer de vous expliquer ces concepts le plus simplement possible.

Crawlabilité et indexation

L’action d’un moteur de recherche qui parcourt le web s’appelle le crawl. Si une page de votre site internet est capitale pour votre positionnement, il faut que Google ait la possibilité de la crawler le plus directement et le plus souvent possible.

Pour que Google accède à cette page, on utilise deux méthodes :

- Le maillage interne : consiste à placer dans une page des liens vers d’autres pages de votre site.

- Le maillage externe : consiste à utiliser des backlinks pour faire des liens vers votre page.

Malgré cela, il se peut que Google ne puisse pas crawler une page. Il peut arriver parfois que des directives aient été placées dans le fichier robots.txt

User-agent: *

Disallow: /*?sort=Cette directive indique à Google qu’il n’a pas le droit d’aller crawler les URL contenant la chaîne ?sort=

Ce type d’instruction est souvent utilisée par les consultants SEO ()Search Engine Optimisation / Référencement naturel) pour améliorer le parcours de Google sur le site.

Dès lors que Google accède à une page, il lui est possible de l’enregistrer dans sa mémoire : c’est ce que l’on appelle l’indexation. Bien sûr, il est possible de lui interdire d’indexer une page. Pour ce faire, on utilise le plus souvent la balise meta robots.

<meta name="robots" content="noindex, follow">Problème d’indexation fin 2021

À partir de l’été 2021, nous avons observé de gros problèmes d’indexation chez Google. Bon nombre de pages, pourtant crawlables et indexables, n’étaient pas prises en compte par le moteur. Et le fait de lancer les pages dans l’outil Google Search Console ne fonctionnait plus…

Cette période a été très compliquée pour nous et nos clients puisque les modifications que l’on apportait sur les pages n’étaient pas indexées.

L’origine de ce problème est encore obscure. Différentes hypothèses ont été évoquées : algorithme cassé, vague de désindexations massives, pages de pauvres qualité non prises en compte …

Des solutions françaises sont alors nées

Dans cette situation, nous avons pu compter sur la communauté des SEO français pour trouver des solutions :

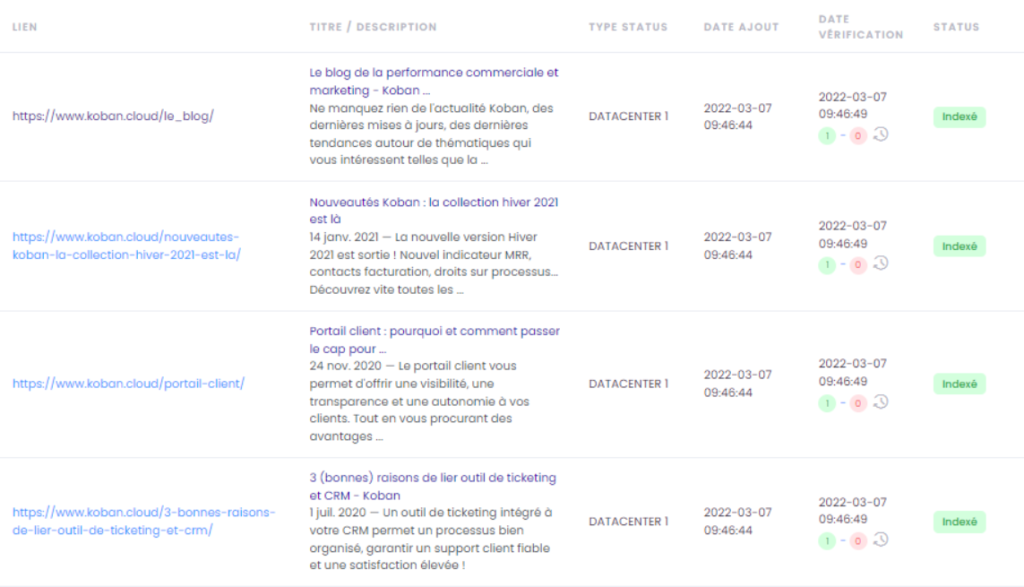

L’outil IsIndexed existait déjà mais a vu son utilité grandir à cette époque ! Cet outil développé par l’un des consultants SEO les plus humbles de la communauté, Stéphane Madaleno, permet de connaître l’état de l’indexation d’un volume de pages donné.

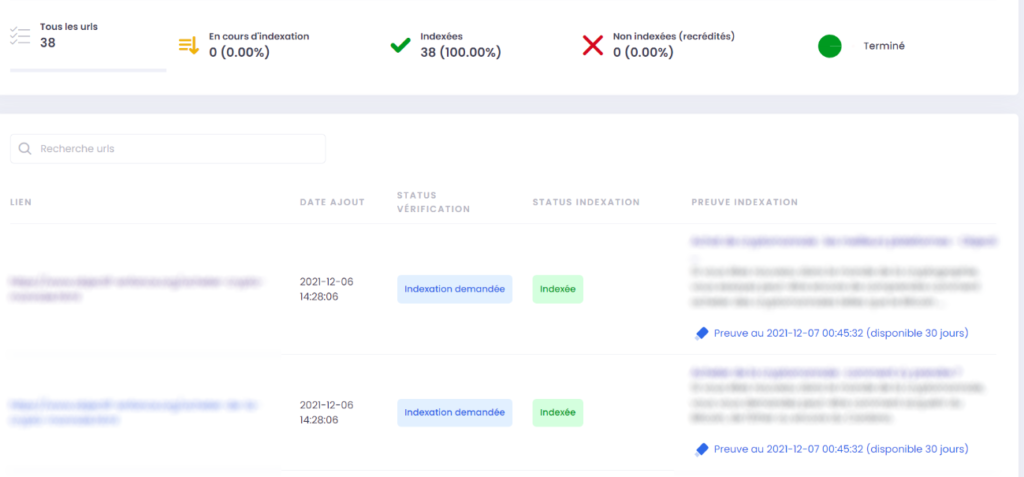

L’outil IndexMeNow, toujours développé par Stéphane Madaleno, est quand à lui né pendant cette période. Cet outil permet de forcer l’indexation d’une page dans Google, et a permis de nous sortir de la difficulté.

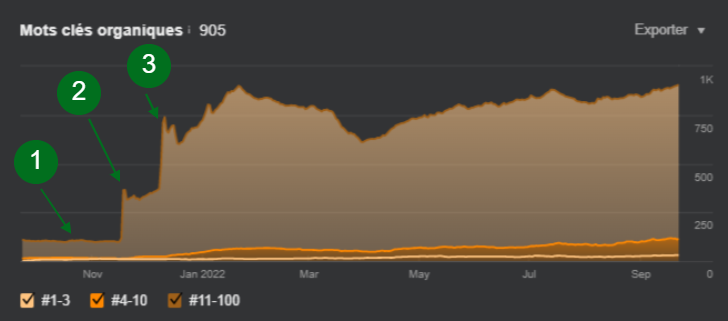

A titre personnel, je me rappelle avoir lancé une migration de site en Novembre 2021 :

- En 1, lancement de la refonte, avec toutes les 301 bien effectuées… Mais aucune nouvelle page indexée ! Du coup, c’est la panique, aucun résultat, positionnement nul…

- Point 2, 1ère salve d’URLs lancée dans IndexMeNow, toutes indexées en moins de 24H, et résultats immédiats au niveau du positionnement.

- Point 3, 2nde salve d’URLs lancée, résultats immédiats encore une fois.

La situation sur l’indexation en 2022

1 an après, la situation est bien meilleure, on dénote bien moins de problèmes d’indexation, et le fait de pousser une URL dans la Search Console fonctionne de nouveau.

Pour autant, les 2 outils ci-dessus sont toujours utiles, notamment concernant le suivi des backlinks. Avec la Search Console, vous ne pouvez pousser que des pages de sites qui vous appartiennent, l’outil IndexMeNow fonctionne pour tous les sites web.

Et concernant l’indexation et mon ressenti global : Google doit ingurgiter de plus en plus de contenus, et l’arrivée de certains logiciels d’Intelligence Artificielle (IA) ne va faire qu’accentuer ce phénomène…

Il risque d’être de plus en plus frileux pour indexer des contenus, notamment pour les sites de faible notoriété et il va falloir de plus en plus lui montrer patte blanche.

Disposer de contenus qualitatifs et différenciants vous apportera cette confiance de la part de Google.

J’entends beaucoup parler de la mort des rédacteurs web avec l’arrivée de l’IA, mais au contraire, je pense que le métier va juste évoluer vers une qualité supérieure, au service de tout le monde finalement : les moteurs indexeront de la qualité, les internautes préfèreront cette qualité, et les entreprises verront leur image de marque améliorée.